Introducción.

El estudio STAR*D es considerado como uno de los más importantes, y para muchos el más significativo en el campo de la evaluación de los antidepresivos.

Fue realizado a mediados de la década pasada por psiquiatras investigadores punteros en el campo del tratamiento farmacológico de la depresión.

El estudio, con sus análisis posteriores, ha dado lugar a bastante más de un centenar de artículos que analizan distintos aspectos del mismo.

Se trata de un ensayo realizado al modo de la clínica de tratamiento farmacológico en la asistencia habitual. Cuando una persona no responde adecuadamente se aumenta la dosis, se cambia de antidepresivo, etc. Consta de cuatro fases de tratamiento, siendo la primera iniciar el tratamiento con la toma de Celexa (citalopran), en España bajo el nombre comercial de Seropran y Prisdal.

Los autores del ensayo mostraron que al año se daba una remisión de los síntomas en el 67 % de los sujetos.

Es especialmente importante porque al día de hoy son muchos los psiquiatras que defienden el tratamiento con antidepresivos en base a los resultados mostrados por los autores de este ensayo y sus artículos. Así el Dr. Guillermo Lahera, profesor de la Universidad de Alcalá, según recoge un diario nacional declaró que el estudio STAR-D, realizado con pacientes en consulta y no en ensayos clínicos, muestra que el tratamiento con antidepresivos consigue una remisión hasta en el 67% de los casos. Algo similar refiere el psiquiatra Miquel Roca, presidente de la Fundación Española de Psiquiatría y Salud Mental y coordinador de la Unidad de Psiquiatría del Hospital Juan March de Mallorca. Lo mismo se recoge también en otros medios.

El estudio STAR*D, que fue financiado con dinero público en USA, y que fue llevado a cabo por psiquiatras líderes de opinión con lazos comerciales con la industria farmacéutica, en concreto con los fabricantes de Celexa, es también interesante como ejemplo de maquillaje y falsificación de los datos desde una perspectiva fraudulenta.

Ed Pigott ha dedicado un ímprobo esfuerzo y tiempo a seguir la pista a los artículos de este estudio y a todo lo referente al STAR*D, habiendo publicado diversos artículos, ver aquí, aquí y aquí. Además ha editado varios posts dedicados al estudio STAR*D. El ensayo STAR*D por su carácter fraudulento ha sido llevado a los tribunales en USA.

Este escrito que presentamos aquí es uno de los elaborados por Pigott, y quiere presentar e interesar al lector hispano las entrañas de este estudio que sigue teniendo un peso máximo en la práctica de recetar antidepresivos a las personas diagnosticadas de depresión.

Texto originariamente publicado en Mad In America (15 de abril de 2017)

Éstos son algunos de los errores científicos que ya he publicado en revistas con revisión entre pares:

- En el Protocolo de Investigación del Estudio STAR*D, se requiere que los pacientes que empezaban a tomar Celexa (citalopram) en la fase 1, y que desertaban sin cumplimentar la Escala de Hamilton de Depresión (HRSD) se contabilizarían como un fracaso del tratamiento. Pero en los resultados publicados, los autores del STAR*D retiraron del análisis a los pacientes con Celexa que no acudieron a la visita de seguimiento, y de este modo agrandaron las tasas de respuesta y remisión adjudicadas a favor del Celexa.

- El protocolo del estudio STAR*D requiere que los pacientes debían tener una puntuación en la escala HRSD basal de 14 o más como requisito para ser incluidos en el análisis de datos. Sin embargo, los autores del STAR*D cambiaron el requisito de los criterios del análisis al publicar los resultados en las fases 2-4 y en los artículos de resumen, sin que se informara de ello a los lectores. Estos cambios permitieron incluir a 607 pacientes inicialmente excluidos porque su puntuación basal era inferior a 14 en la HRSD, lo que significaba que como mucho tenían síntomas depresivos leves. Del mismo modo, más adelante se añadió a 324 pacientes excluidos inicialmente porque no tenían la referencia basal del HRSD. Es decir, 931 de los 4041 pacientes del STAR*D (23%), no cumplieron los requisitos del criterio de análisis para la fase 1 del STAR*D pero más adelante fueron incluidos para los resultados de las fases 2-4 que se publicaron y en los artículos de resumen. La inclusión de estos pacientes que no se debían incluir infló los resultados publicados.

- En el protocolo del STAR*D se especificó que la escala HRSD sería la medida principal para mostrar los resultados de la investigación y los mismos autores del STAR*D citan a la HRDS como la medida estándar de oro para investigar la depresión. Los autores del STAR*D sin embargo pasaron a utilizar la escala, con derechos de autor, Quick Inventory of Depressive Symptoms-Self-Report (QIDS-SR) –Inventario Rápido de Síntomas Depresivos – Auto-informe (QIDS-SR)– como la medida única que mostraba los resultados en el artículo resumen. El Dr. John Rush tiene derechos de autor de la QIDS-SR, y es el investigador principal (PI) del STAR*D. Este cambio en la forma de medir los resultados tuvo un impacto dramático al inflar las tasas de la remisión y respuesta publicadas del STAR*D. Como he documentado anteriormente, la tasa de remisión con Celexa se infló en un 44,9% en el artículo de resumen. En referencia a las declaraciones de intereses, diez de los autores del STAR*D indican haber recibido dinero del fabricante de Celexa, Forest Pharmaceuticals (Pigott, 2011, p.19).

- En el protocolo del STAR*D, se excluyó expresamente el uso de la versión clínica del QIDS-SR como medida de resultados de la investigación. Los autores del STAR*D sin embargo usaron la QIDS-SR, propiedad del PI, como medida secundaria para mostrar las tasas de remisión, y como medida única para mostrar las tasas de respuesta en seis artículos publicados sobre «las etapas 1-4». El usar la QIDS-SR tuvo un impacto que infló significativamente las tasas de remisión y respuesta publicadas del STAR*D.

- Tras haber cambiado la medición desde el modelo de referencia, al QIDS–SR, propiedad del PI, los autores del STAR*D realizaron declaraciones falsas en los artículos que publicaron para poder justificar este cambio. Esta alteración de los hechos incluyó afirmaciones falsas como que “la QIDS-SR no fue usada para tomar decisiones sobre el tratamiento» (Rush et al., 1998), a pesar de que esta afirmación contradice directamente lo que los propios autores escribieron en el artículo de la fase 1, «Para mejorar la calidad y consistencia de la asistencia, los médicos usaron el sistema de apoyo a las decisiones clínicas basándose en la medición de los síntomas (QIDS-C y QIDS-SR), los efectos secundarios (tasa de frecuencia, intensidad y carga), la adherencia a la medicación (auto-informada), y el juicio clínico basado en la evolución del paciente» (Trivedi et al., 2006, p. 30), y también se opone a todos los documentos de fuente primaria (por ejemplo, véase la sección STAR*D de documentos del blog; Protocolo de Investigación y del Plan Analítico p. 47-48 y STAR*D. Manual de Procedimientos Clínicos, tablas 2-4, p. 119-121, así como el artículo de Ensayos Clínicos Controlados de Rush et al., 2004).

- En el protocolo del estudio STAR*D, se recogen 11 medidas de investigación pre-especificadas para evaluar los resultados al inicio y final de cada etapa de tratamiento, y cada tres meses en los 12 meses de seguimiento asistencial. Sin embargo, aunque se han publicado más de 100 artículos, los autores del STAR*D no han mostrado ninguno de los resultados de estas 11 mediciones de investigación, excepto las tasas de remisión HRSD en los artículos de la etapas iniciales 1-4, en vez de ello los autores del STAR*D han usado repetidamente la escala substituta QIDS-SR para mostrar los resultados sin revelar que había sido expresamente excluida para este uso.

- Los autores del STAR*D inflaron el grado de mejoría de los pacientes que llegaban a alcanzar la remisión con numerosas afirmaciones falsas sobre los pacientes del STAR*D que fueron puntuados como si estuvieran en remisión “consiguiendo el alivio completo de (su) episodio depresivo» y que consiguieron «la ausencia total de los síntomas depresivos», así como que «llegaron a estar libres de síntomas» (Pigott, 2011, páginas 17-18, 20). Los autores del STAR*D hicieron esas afirmaciones falsas, aunque un paciente pudiera tener una puntuación de 7 en la escala HRSD, y a pesar de ello era clasificado como si hubiera alcanzado la remisión. Una puntuación de 7 o menos en el HRSD no equivale a no tener síntomas. Por ejemplo, en lo referente al suicidio en la HRSD, «siente como si la vida no mereciera vivirse» se califica con sólo 1 punto. Otros síntomas depresivos significativos que se califican con un sólo 1 son «se siente inferior a la gente» y «se siente incapaz, apático, y con poca energía». Un paciente con una puntuación 1 en cada una de estas tres preguntas en el HRSD era contabilizado como en remisión, y todavía podría tener cuatro síntomas más, aunque ningún profesional diría que ese paciente se encontraba sin síntomas, y es que son estos síntomas los que se usan al diagnosticar la depresión mayor.

- En el artículo de resumen del estudio STAR*D hay un patrón de errores de redondeo, que inflan una y otra vez las supuestas tasas de remisión y respuesta en las etapas 1-3 (Pigott, 2011, p. 16-17). En seis ocasiones el STAR*D no calcula de forma precisa y muestra porcentajes simples, y en cada uno de estos errores de redondeo infla aún más los resultados mostrados. Si bien es cierto que es algo mínimo, creo que la consistencia de este patrón (6 de 6) es muy significativa respecto a la cuestión de que uno o varios de los autores del STAR*D quiso inflar los resultados de las tasas de remisión y respuesta.

- Los autores del STAR*D no dieron a conocer que del total de los 4.041 pacientes del STAR*D que empezaron tomando Celexa en la primera visita y tras los cuatro ensayos de tratamiento, solo 108 pacientes (2,7%) alcanzaron una remisión completa y no recayeron o no abandonaron en los 12 meses que duró la asistencia de seguimiento libre. Este es el error más dañino de los autores del STAR*D, el que omitieron comunicar la eficacia ínfima de la perspectiva de probar-probar-probar y volver a probar del tratamiento con antidepresivos del STAR*D. En cambio, los autores del estudio STAR*D calcularon de un modo falso una tasa de remisión teórica del 67% con estos fármacos. Esta afirmación falsa es profundamente engañosa para los que sufren de depresión, para los profesionales, para los que diseñan la política asistencial, y para el público en general, ya que la cifra del 67% se ha usado varias veces para propagar el uso generalizado de los antidepresivos.

Añadir una ficción a otra

En mi primer blog, di cuenta del artículo más reciente de los autores del STAR*D que usaron como medida única de resultados la escala substituta QIDS-SR. El artículo titulado «Síntomas residuales en pacientes ambulatorios con depresión que obtuvieron una respuesta del 50%, pero no alcanzaron la remisión con la medicación antidepresiva», se ha publicado este mes en la edición de la revista Journal of Clinical Psychopharmacology.

Mientras pensaba en mi segundo blog, decidí a leer el artículo del JCP en su totalidad en vez de confiar sólo en el abstract para ver qué cosas nuevas podrían decir los autores del STAR*D en este último análisis al usar la escala substituta QIDS-SR. Así que en la madrugada del 29 de marzo pagué los $35 de la tasa de descarga y empecé a leerlo.

Me dejó atónito leer la exposición de las Medidas de Evaluación del artículo “En las 72 horas tras cada visita clínica, un sistema telefónico de respuesta interactiva hablada recogía los 16 ítems del auto-informe QIDS-SR” (el subrayado es nuestro; McClintock et al., 2011, p 181). Leí una y otra vez con incredulidad esta frase.

Una vez repuesto, mi primera reacción fue la de que me había equivocado, de algún modo no tenía este fragmento de información fundamental.

Tengo miedo de descubrir que me he equivocado en mi trabajo de investigación, por ello me obsesiono con la documentación de múltiples fuentes. Entonces exploré rápidamente las lista de tablas –y delimitar claramente— las evaluaciones en las visitas clínicas del STAR*D, y las mediciones de resultados de la investigación que se indican en los documentos de la fuente primaria del STAR*D. Más importante aún, estas tablas dicen cómo y cuándo se realizó cada medición y estas declaraciones son idénticas en el Protocolo de Investigación, el Manual de Procedimientos Clínicos, y el artículo de los Ensayos Clínicos Controlados del STAR*D.

Pude respirar de nuevo. La descripción metodológica del trabajo del artículo de McClintock et al. ¡era pura ficción! Eso no sucedió así. Me senté allí paralizado por la incredulidad. ¿Cómo podía ocurrir esto? Rush, Trivedi, Wisniewski, Nierenberg, Stewart, Cook y Warden eran los coautores y cada uno de ellos había sido uno de los autores principales en uno o más de los informes del STAR*D financiados por el NIMH.

A continuación, recordé el articulo de Nierenberg et al. de 2010, titulado, «Síntomas residuales tras la remisión del Trastorno de Depresión Mayor con citalopram y riesgo de recaída: Un informe del STAR*D» publicado en Psychological Medicine. Ya cité las estadísticas de este artículo en el mío sobre los sesgos del STAR*D, pero las recogí tan sólo mediante la lectura del abstract del artículo, porque no quise pagar los $45 que costaba descargarlo.

Descargué este artículo y allí estaba. «Los participantes completaron el QIDS-SR al iniciar el estudio y en cada visita de evaluación de los síntomas depresivos. El auto-informe FIBSER fue completado por los participantes tras cada visita, para evaluar los efectos secundarios. Ambas medidas fueron recogidas dentro de las 72 h de cada visita usando un sistema de respuesta interactiva de voz por teléfono (IVR)»(el subrayado es nuestro, Nierenberg et al., 2010, p. 43).

Una vez más me quedé pasmado, sentí como si entrara en zona de penumbras y eran sólo las 5:30! El artículo de Nierenberg et al. incluía al Dr. Maurizio Fava y también a los Dres. Rush, Trivedi, Warden, y Wisniewski en su ilustre lista de autores. ¿Cómo podía pasar esto?

A continuación, me centré en las etapas 1-4 del STAR*D y los artículos de resumen, siete en total. Busqué en los archivos PDF de estos artículos utilizando los términos teléfono, interactivo, voz, IVR, etc., porque en estos artículos se describe la metodología STAR*D con detalle. Como quedó claro a través de esta búsqueda, las pocas veces que se refiere a la versión IVR del QIDS, se especifica que se administró esta versión de la QIDS al inicio y fin de cada etapa, 6 semanas era la duración de cada etapa, y mensualmente durante el seguimiento. Simplemente no se administraba la versión IVR de la QIDS-SR «dentro de las 72 horas de cada visita clínica».

La única versión de la escala QIDS-SR que se ligaba a cada visita clínica era de papel y lápiz y sin cegar. Las declaraciones falsas de los autores del STAR*D respecto a la administración del QIDS-SR parecen diseñadas para darle credibilidad como medida de investigación, ya que, por definición, una versión IVR está cegada respecto al estado de los pacientes, y por lo tanto es una fuente de datos imparcial; pero esto no se hizo así.

¿Por qué esto resulta importante?

Es de importancia fundamental para los lectores de la revista entender los procedimientos del STAR*D usados al administrar la versión clínica de QIDS-SR, ya que estos procedimientos invalidan su uso como medida de investigación.

En primer lugar, los pacientes del STAR*D rellenaron una versión de lápiz y papel del QIDS-SR al inicio de cada visita clínica, que supervisaban los coordinadores de investigación clínica (CRC) no cegados. El Manual de Procedimientos Clínicos requería que a continuación los CRC revisaran los resultados QIDS-SR para asegurarse de que se rellenaban todos los ítems y después vieran al paciente para administrarle «el material adecuado de Educación para el Paciente» (Trivedi et al., 2002, p. 75).

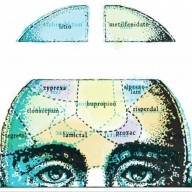

A continuación, el CRC administraba un programa educativo, de múltiples niveles a los pacientes y las familias, basado en la teoría del desequilibrio neuroquímico de la depresión, e incluía «una representación visual coloreada del cerebro y los neurotransmisores,» de forma consistente se hacia hincapié en que «la depresión es una enfermedad, como la diabetes o la presión arterial alta, que no es causada por algo que el paciente hubiera hecho o no. (La depresión es una enfermedad, no una debilidad o defecto del carácter.) El [CRC] educador debía enfatizar que la depresión puede tratarse con la máxima eficacia como otras enfermedades» y «explicar los principios básicos del mecanismo de acción” del Celexa, al tratar su depresión [O’Neal y Biggs, 2001, pp 4-7].

Por último, los CRC administraban el QIDS-C, la versión del QUID recogida por el clínico, con las mismas 16 preguntas y opciones de respuesta que el QIDS-SR. A continuación, el CRC tenia que debatir sobre «cualquier síntoma y los efectos secundarios que el paciente pudiera experimentar» y registrar tanto la información QIDS-SR y QIDS-C en el formulario de registro clínico para que la revisara el médico tratante antes de ver al paciente (Trivedi et al., p. 75). Esto se hacía «para suministrar la información consistente para que los médicos la usaran dentro del protocolo» (Rush et al., 2004, p. 128).

A la vista de lo expuesto, resulta claro por qué se pre-especificó que la versión clínica del QIDS-SR sería excluida explícitamente para ser usada como medida de investigación. En primer lugar, habría efectos de sesgo de la demanda[1] significativos en las condiciones en las que se administraba, sesgando cualquier informe de resultados para el QIDS-SR en el estudio abierto del STAR*D. En segundo lugar, resulta simplemente incorrecto desde un punto de vista científico usar una medida de auto-informe, no cegado, como el QIDS-SR, usarla a su vez también como guía de asistencia clínica en cada visita, y además evaluar los resultados, partiendo de dicha atención en el ensayo abierto (o para cualquier ensayo de este tipo). Por otra parte, el hecho de que el QIDS se administrara dos veces en cada visita clínica hace del uso de la misma escala como medida de investigación doblemente absurdo, en términos de tener algún valor científico, que no sea el documentar los efectos de sesgo de la demanda que se produce en estas circunstancias.

Otra sorpresa

Después de recuperarme de esta serie de shocks, y leer ambos artículos para ver de que informaban. ¡Otro shock! Dentro del habitual galimatías, ambos artículos usaban el substituto QIDS-SR para minimizar radicalmente el alcance de la ideación suicida que aparecía entre los pacientes con Celexa en el STAR*D, que se consideraba que estaban en remisión o habían respondido a este medicamento.

Por ejemplo, el abstract de McClintock et al. afirma que «la ideación suicida fue el síntoma menos frecuente que apareció en el tratamiento (0,7%)», y luego en la sección de discusión, concluyen, «Curiosamente, las tendencias suicidas en muy raras ocasiones aparecieron durante el transcurso del tratamiento, y las tendencias suicidas como síntoma depresivo residual persistente fue observado muy raramente. Por otra parte, la tendencia suicida se observó raramente, incluso en presencia de otros síntomas depresivos residuales. Al haber resultados opuestos en las investigaciones referentes a la asociación entre el uso de antidepresivos y las tendencias suicidas, este estudio ofrece una nueva evidencia que sugiere que hay poca o ninguna relación entre el uso de un inhibidor selectivo de la recaptación de la serotonina y la ideación suicida auto-informada» (p. 183). El artículo Nierenberg et al. contiene afirmaciones falsas similares.

Al ser casi un idiota sabio sobre todas lo referente al STAR*D (mucho más idiota que sabio), rápidamente cotejé directamente estos dos artículos recientes con otros dos artículos del STAR*D de 2.007 publicados en American Journal of Psychiatry y Archives of General Psychiatry, ambos se centraban en los predictores genéticos para una mayor ideación suicida durante el tratamiento de Celexa. Estos dos artículos fueron considerados muy importantes al publicarse. De hecho, las patentes de estos predictores genéticos fueron registradas, el Dr. Rush estaba en la lista de quienes presentaron dichas patentes, y por lo tanto también tenía un interés financiero en su uso (por ejemplo, ver el blog Furious Seasons de Felipe Dawdy que muestra estas solicitudes de patente, y ver también las declaraciones de intereses. Así que, claramente, en las mentes de algunas personas –supongo que al menos la del Dr. Rush– los hallazgos de estos estudios del AJP y AGP eran importantes.

El artículo de AJP encuentra que 120 de 1.915 pacientes (6,3%) refirieron tener ideación suicida aparecida tras tomar Celexa, basándose en el análisis de los datos de las mediciones repetidas del QIDS-SR (Laje, Paddock, Manji, Rush, et al., 2007), mientras que el artículo de AGP encontró que 124 de 1.447 pacientes (8,6%) comunicaron ideación suicida aparecida cuando tomaban Celexa, en base a un análisis similar con el QIDS-C (Perlis, Purcell, Fava, Fagerness, Rush, Trivedi, et al., 2007).

Siendo co-autores en estos anteriores artículos, Rush, Trivedi, y Fava conocían claramente los resultados de ambos estudios, y en los dos se hallaron importantes tasas de ideación suicida aparecida en el tratamiento con Celexa, sin embargo optan por no mostrar estas pruebas opuestas, tanto en el articulo de McClintock et al. como en el de Nierenberg et al. En vez de ello, el documento de McClintock et al. indica que «La aparición de ideación suicida fue el síntoma menos frecuente durante el tratamiento (0,7%)».

El simple hecho es que 0,7% ante 6,3% o 8,6% es una diferencia significativa en la tasa notificada de la ideación suicida aparecida durante el tratamiento con Celexa. ¿Por qué esta información opuesta no se muestra en estos dos artículos? ¿Se pueden maquillar tan fácilmente los datos de QIDS sin que digan nada? ¿Se podría deber al hecho de que la mayoría de los autores principales del STAR*D (por ejemplo, Rush, Trivedi, Fava y Nierenberg) estaban ligados a Forest Pharmaceuticals, el fabricante de Celexa, según sus declaraciones de intereses?

Incluso si no hubiera un quid pro quo entre Forest y uno o más de los autores (y con la certeza al 99.999% de que este no es el caso), dado que se trataba de un estudio financiado por el NIMH, el mero hecho de que los autores clave tengan tantos vínculos con la industria farmacéutica pudiera hacer que, incluso el más riguroso de ellos, inconscientemente tienda a buscar y resaltar los hallazgos positivos y minimizar los negativos, sobre todo si esa línea de investigación constituye el grueso del trabajo de su vida profesional.

Una búsqueda rápida en PubMed muestra que los Dres. Rush, Trivedi, Fava y Nierenberg han publicado 1.697 artículos en revistas revisadas inter-pares, entre todos ellos, y la gran mayoría se centraban en torno a la depresión y su tratamiento con antidepresivos. Quizás por eso, estas luminarias pueden anunciar que, «este estudio muestra nuevas evidencias que sugieren poca o ninguna relación entre el uso de un inhibidor de la recaptación de serotonina y la ideación suicida auto-informada». Tal vez realmente han llegado a creer esta afirmación falsa, o quizás han publicado tantos artículos que han olvidado lo que dijeron en los escritos previos, y que publicar artículos tan contradictorios sobre la aparición de ideación suicida en el tratamiento –y el no revelar tales contradicciones- no sea algo infrecuente. Básicamente, se trata de la defensa de Steve Martin, ante no haber pagado nunca impuestos y otra serie de delitos, de dos simples palabras: Juez, «se me olvidó…» (ver: http://snltranscripts.jt.org/77/77imono.phtml).

Esta última hipótesis tiene apoya en que éstos autores del STAR*D en la etapa 1 declararon que el QIDS-SR era parte de su sistema de apoyo para la decisión clínica y luego más tarde, cuando este hecho se convirtió en un inconveniente, afirmaron falsamente que el QIDS-SR «no se usó para tomar decisiones de tratamiento». ¿Puede que se les olvidara? Otras pruebas que apoyan esta hipótesis es que estos autores clave parecen olvidan muchos detalles del protocolo de investigación STAR*D, en particular los referentes al uso del grupo de los productos QIDS, el QIDS-SR, QIDS-C, y QIDS-IVR de propiedad del PI. Teniendo en cuenta el volumen mensual de artículos, revisados inter-pares, del que son autores estos investigadores en revistas de primer nivel, es fácil ver como pueden ser tan olvidadizos en lo referente a estos tres QIDS.

Si leen mi biografía, verán que soy socio de una empresa de neuroterapia, consultor de empresas con fines lucrativos, y estoy orgulloso de que nunca he mantenido una postura académica. Mi consultora ha participado frecuentemente supervisando estudios y análisis de líneas de investigación, incluyendo la redacción de informes de las mismas. Soy bastante bueno en esto, y tengo un don especial en la deconstrucción de la investigación y la identificación de defectos de la misma, aunque no aplico necesariamente el mismo nivel de indagación sobre los productos y servicios de las empresas que me han contratado. Me esfuerzo en hacer mi trabajo con integridad (y no recuerdo haber mentido u ocultado en las conclusiones, ni que se me haya pedido hacerlo), pero como la mayoría de la gente, por lo general tiendo a creer en el valor de lo que estoy investigando, y por eso tienen que protegerme contra el sesgo de confirmación, es decir la tendencia que tenemos todos para poner mentalmente de relieve la información que confirma nuestros prejuicios mientras empequeñecemos las pruebas contrarias.

Tampoco es necesario ser un científico de primera, ni que lo sea Rush et al., para darse cuenta de que las empresas con fines lucrativos no mantendrán nuestra participación y nos pagarán si destapamos y publicamos información que daña a la comercialización de sus productos (en mi curriculum se puede ver que varias de las empresas con las que he hecho consultorías en el pasado también contrataron a Rush u otros autores del STAR*D). Pero se suponía que el STAR*D era diferente. Fue financiado por el NIMH, un estudio de oportunidad, sin embargo ha sido plagado de errores científicos al presentar sus resultados en más de 100 estudios. Este déficit científico no sólo no significa un avance en el campo de la depresión y su tratamiento, sino que es posible que de hecho también perjudique directamente la asistencia al paciente como lo demuestran estos dos artículos más recientes.

Una petición de retracción de los artículos

Antes de la publicar «STAR*D: A Tale and Trial of Bias» me puse en contacto con los Dres. Jon Jureidini y Leemon McHenry, para recoger y obtener su consejo sobre cómo retractar el artículo resumen del STAR*D que se publicó en AJP junto a varios otros artículos. Quería saber que aprendieron de su labor para que el infame Estudio 329 fuera retractado del Journal of the American Academy of Child and Adolescent Psychiatry, después de leer el editorial titulado, «Las reglas de la Retracción» publicado en el British Medical Journal.

Los Dres. Jureidini y McHenry me brindaron mucha ayuda y me dieron tanto su correspondencia con los editores de JAACAP y también sus extensas pruebas del enorme sesgo de la investigación del Estudio 329, así como la documentación de múltiples infracciones de la política editorial explicitada de esta revista.

Mientras que al día de hoy el esfuerzo de los Dres. Jureidini y McHenry no ha tenido éxito, mi examen de su enfoque resulta fundamental para aprender sobre mi compromiso: conseguir la retracción del castillo con más de 100 naipes del STAR*D, que es mi motivo principal para emprender este blog.

Basándome en la información recogida desde la Ley de Libertad de Información –Freedom of Information Act–, más otras cosas desagradables con las que me topé, supe que había mucha información dañina que todavía debía desvelar, y que una vez divulgada esta nueva información adicional podría socavar la confianza en la integridad científica del STAR*D.

Dado que no creo que el STAR*D sea una conspiración planificada previamente en la que participaron más de 20 autores, mi esperanza era y es conseguir que uno o más de estos autores reflexionen sobre lo que he encontrado, algo de lo que puede que no fueran plenamente conscientes en el momento en que accedieron a que sus nombres fueran incluidos como autores, y que su reflexión les lleve a retirar su nombre de uno o más de los artículos del STAR*D. Fue así como The Lancet desechó el estudio del autismo y las vacunas, ejecutando la retracción muchos años después de su publicación. Los investigadores honestos decidieron que no querían que su buen nombre se asociara a lo que conocieron retrospectivamente sobre el sesgo de la investigación. Admitir esto requiere integridad y coraje, ya que significa colocarse en contra de los propios compañeros, pero esperaba que uno o más del plantel de los autores del STAR*D tendría la honradez y el valor de dar este paso.

Aunque este era un buen plan, los artículos del JCP y Psychological Medicine lo cambia todo ya que ahora la información falsa se distribuye a través de las revistas de primera línea, lo que puede dañar directamente la atención al paciente. Así que escribí cartas para la retracción a las dos revistas que publicaron estos artículos más recientes (ver Cartas de Retracción al JCP y Psychological Medicine en la sección de Documentos de Retracción). Aunque estoy sesgado, creo que merecen la pena leerse estas cartas de retracción.

En la carta que envié a JCP: «Por otra parte, mientras que McClintock et al. informan de que la tendencia suicida ‘era un síntoma depresivo residual persistente raramente observado’ puede de hecho deberse simplemente a los efectos de sesgo de la demanda, tal cómo se administró el QIDS-SR, de modo que algunos pacientes suicidas dejaron de informar sobre el tema del suicidio porque ya no querían hablar de este síntoma con el CRC, mientras que estaban más dispuestos a reconocer otros síntomas menos evocadores. En pocas palabras, la ciencia de calidad inferior como se evidencia en el articulo de McClintock et al., y en muchos de los artículos del STAR*D, no sólo no son un avance en el campo de la depresión y su tratamiento, es posible que de hecho también perjudique directamente la asistencia al paciente».

Debido a este riesgo de dañar al paciente, envío estas cartas y toda la correspondencia posterior. Los co-editores del JCP respondieron con prontitud y de manera apropiada (ver la respuesta de JCP Editors en la sección documentos de retracción). Aunque creo que los editores minimizan tanto su responsabilidad en la investigación como su capacidad, actuaron claramente con integridad y celeridad adecuada.

Estoy considerando la oferta de los editores para presentar una carta a JCP y si la aceptan, entonces se dirigirán a McClintock et al. para que respondan. Con suerte, esta carta se difuminará tras una semana después de obtener las aclaraciones de los editores del JCP, si mi carta se limita a “6 páginas a doble espacio, incluyendo las referencias» como se indica en su página web.

También pregunté a los editores que me indicaran según sus criterios que se necesita probar para que JCP retracte el artículo de McClintock et al. Estoy totalmente en desacuerdo con los editores del JCP cuando declaran que los puntos planteados en mi carta para la retracción simplemente «pertenecen al campo de los comentarios acerca del contenido científico» (ver Pigott, Respuesta a la carta de de la JCP). En mi sencilla opinión, los criterios para la retracción son muy claros; es decir, ¿deberían ser los revisores inter-pares y los editores de JCP que publicaron el artículo de McClintock et al. tal como está escrito, si los errores científicos tal como se documentan en mi carta de retracción demuestran ser ciertos? Si probaran ser ciertos, estos errores no son un simple comentario sobre el contenido científico, sino que en realidad prueban la elaboración de contenidos científicos que pueden perjudicar la atención al paciente.

Me sentí menos satisfecho con la respuesta del co-editor del Psychological Medicine, el Dr. Kendler, que en sus primeras frases dice: «Junto a mi equipo, hemos revisado el material que envió y no encontramos justificación alguna para retirar este artículo» (véase la Réplica del co-editor a la Carta de Psychological Medicine en la sección Documentos de Retracción).

Al igual que con el JCP, consideraré la oferta del Dr. Kendler de “escribir una carta al editor, que resuma sus inquietudes, estaríamos dispuestos a considerar su publicación usando los procedimientos habituales (por ejemplo, una revisión inter-pares rigurosa). Nuestro límite normal es de 500 palabras y 10 referencias. La carta tiene que centrarse en los temas de investigación implicados y evitar ataques ad hominem”. Aunque primero quiero conseguir que el Dr. Kendler me aclare si una vez que lo que documento demuestre ser cierto, ¿sobre que base, él y su equipo, juzgan que esta información no aporta «justificación alguna para retirar este artículo». Le he preguntado al doctor Kendler que si esta información no proporciona motivos para justificar la retracción, ¿cuáles podrían serlo?

Como se podrá observar, mi carta de respuesta al Dr. Kendler es algo más crítica que mi respuesta a la JCP, en concreto desafío a Psychological Medicine sobre la rigurosa revisión inter-pares aplicada al artículo de Nierenberg et al. (ver Pigott carta de respuesta a Psychological Medicine). Espero que el doctor Kendler no considere esto como un ataque ad hominem, sino como una crítica basada en hechos que documenta que no se hizo, por parte de Psychological Medicine, una revisión editorial y entre pares más o menos competente, por no hablar de una revisión rigurosa entre pares. Como se señala en esta carta, un factor que pudo contribuir a este fracaso pudo ser que el Dr. Rush forme parte tanto del Consejo Editorial de Psychological Medicine como del revisor, sabiendo que el artículo de Nierenberg et al. es uno más de los 100 informes del STAR*D, y de este modo puede darse una ruptura en el proceso normal y riguroso de la revisión inter-pares.

Posdata

Mi próximo post documentará los numerosos errores científicos de omisión y comisión que se produjeron al establecer la fiabilidad psicométrica del QIDS-SR para que en el abstract del artículo de Rush et al. 2006 en Biological Psychiatry se concluya falsamente que: «En pacientes ambulatorios no psicóticos con TDM (Trastorno Depresivo Mayor) sin deterioro cognitivo evidente, la evaluación clínica de la gravedad de la depresión utilizando bien sea el QIDS-C16 o el HRSD17 puede reemplazarse satisfactoriamente tanto por un auto-informe como por la versión IVR del QIDS”.

Este informe del estudio STAR*D es poco mas que basura subvencionada por el NIMH para que los autores del STAR*D puedan justificar su abandono del patrón oro HRSD como medida principal de resultados de este estudio, y su sustitución por el QIDS-SR propiedad del Investigador Principal (PI) que todos los documentos de fuente primaria excluían explícitamente para este uso.

Cambiar el estándar de oro por casqueria. ¿Cómo pudo suceder algo así en un estudio financiado por los contribuyentes con $35 millones de dólares? Tal vez se les pasó por alto a todos, a los autores del estudio STAR*D, a sus supervisores del NIMH, y a los revisores y editores de los más de 100 artículos. Steve Martin estaría orgulloso de ofrecerles su sencilla e infalible defensa, “Es que no nos dimos cuenta…”

[1] Sesgo de la demanda: la corrupción de la investigación cuando los sujetos suponen conocer o conocen realmente la agenda de investigación. Esto puede ocurrir cuando el patrocinador de la investigación revela a los investigados, en la investigación, las respuestas que se buscan.